Apple har släppt kompakta OpenELM-språkmodeller för att köras på prylar

Mohamed M/Unsplash

Apple har presenterat lättviktiga OpenELM-språkmodeller som kan köras lokalt på enheter utan molnanslutning.

Här är vad vi vet

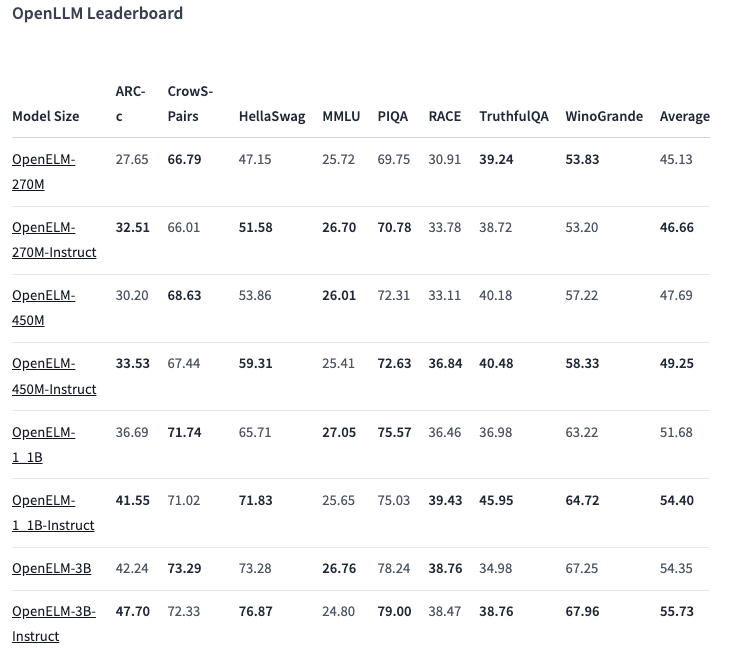

Det finns åtta modeller av två typer i OpenELM-sortimentet - förtränade och anpassade efter instruktion. Varje variant finns tillgänglig med 270 miljoner, 450 miljoner, 1,1 miljarder och 3 miljarder parametrar.

Modellerna förtränades på publika dataset med 1,8 biljoner tokens från webbplatser som Reddit, Wikipedia, arXiv.org och andra.

Tack vare optimeringar kan OpenELM fungera på vanliga bärbara datorer och till och med på vissa smartphones. Testerna genomfördes på datorer med Intel i9 och RTX 4090, samt MacBook Pro M2 Max.

Enligt Apple visar modellerna bra prestanda. Den 450 miljoner parametervarianten med instruktioner sticker särskilt ut. Och OpenELM-1.1B överträffade sin GPT-motsvarighet OLMo med 2,36%, samtidigt som det krävdes hälften så många tokens för förträning

I ARC-C-riktmärket, som är utformat för att testa kunskap och resonemangsfärdigheter, visade den förtränade OpenELM-3B-varianten en noggrannhet på 42,24%. Däremot fick den 26,76 % och 73,28 % på MMLU respektive HellaSwag.

Företaget har publicerat OpenELM-källkoden på Hugging Face under en öppen licens, inklusive tränade versioner, benchmarks och modellinstruktioner.

Apple varnar dock för att OpenELM kan ge felaktiga, skadliga eller olämpliga svar på grund av bristande säkerhetsåtgärder.

Källa: Apple VentureBeat