Opera uppdaterar sin webbläsare för att lägga till stöd för lokala AI-modeller

Opera, ett företag som aktivt investerar i artificiell intelligens (AI), har presenterat en ny funktion som ger användarna tillgång till lokala AI-modeller direkt från webbläsaren.

Det här är vad vi vet

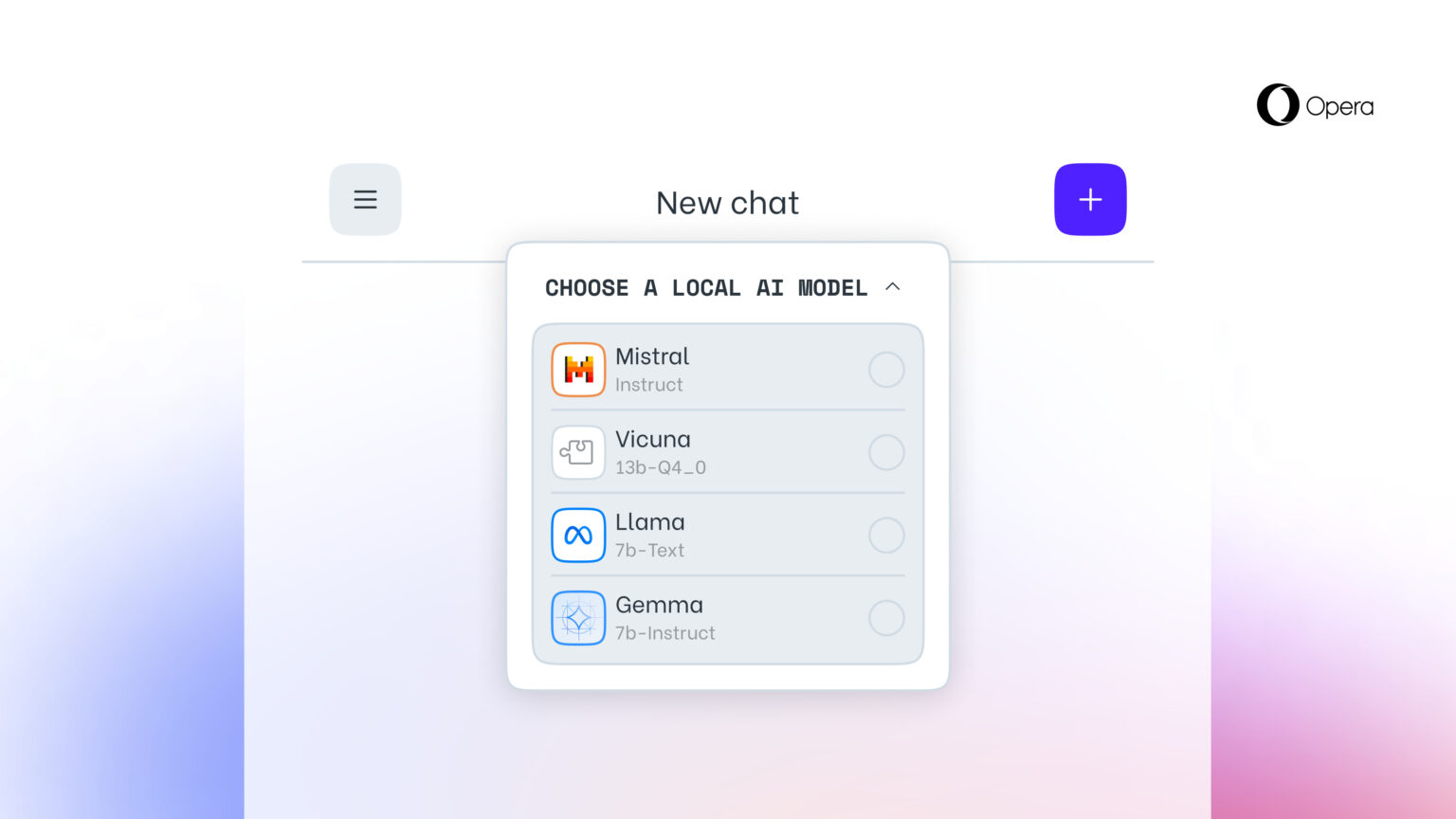

Detta alternativ, som ingen annan webbläsare ännu erbjuder, möjliggörs genom att lägga till experimentellt stöd för 150 varianter av lokala stora språkmodeller (LLM) från cirka 50 modellfamiljer.

Lokala AI-modeller är ett tillägg till Operas onlinetjänst Aria AI, som också är tillgänglig i Operas webbläsare på iOS och Android. Bland de lokala LLM:er som stöds finns modeller som Llama (Meta), Vicuna, Gemma (Google), Mixtral (Mistral AI) och många andra.

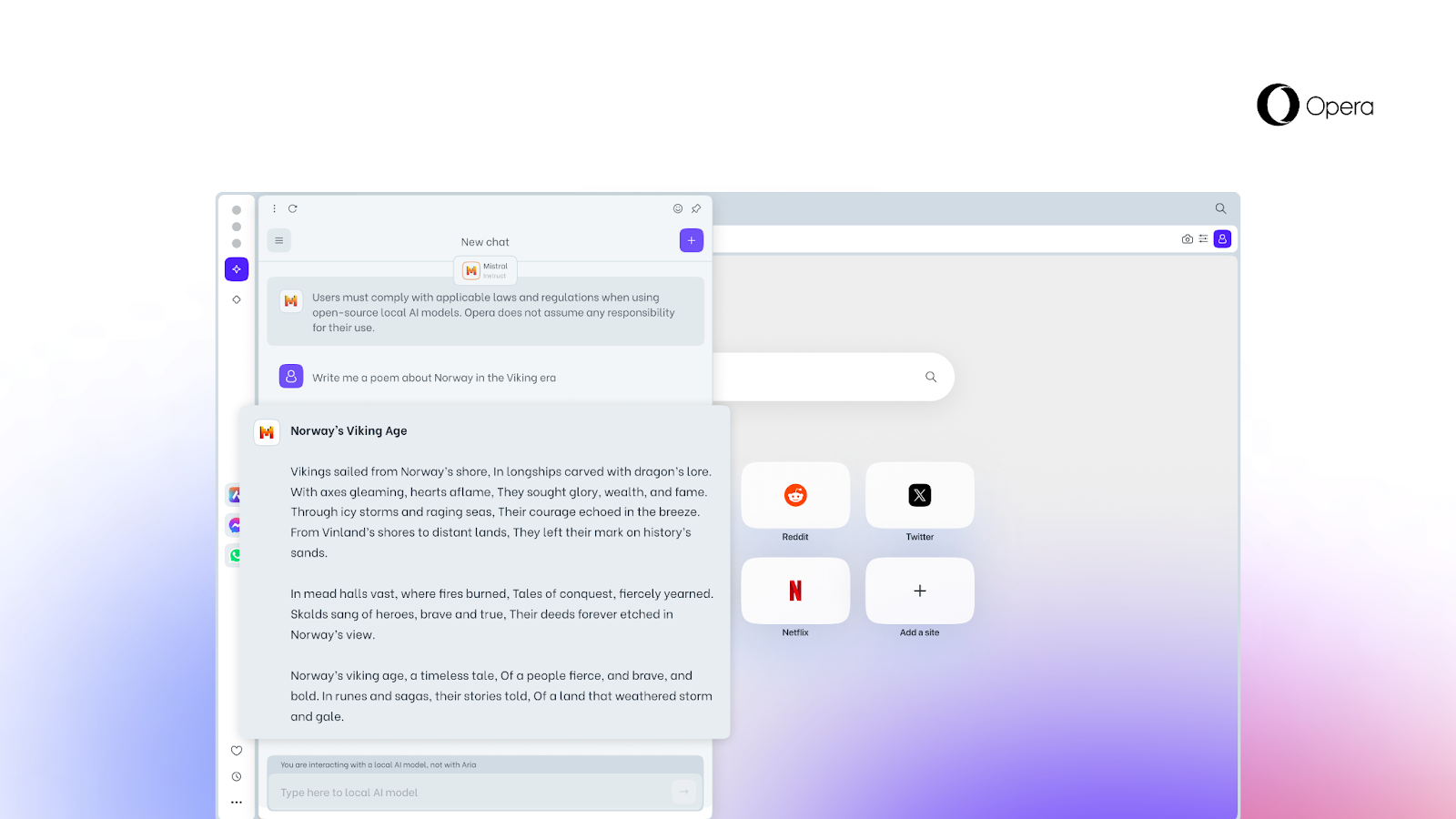

Den nya funktionen är särskilt viktig för dem som vill behålla sin integritet när de surfar på webben. Möjligheten att komma åt lokala LLM:er från Opera innebär att användarnas data lagras lokalt på deras enhet, vilket gör att de kan använda generativ AI utan att behöva skicka information till en server.

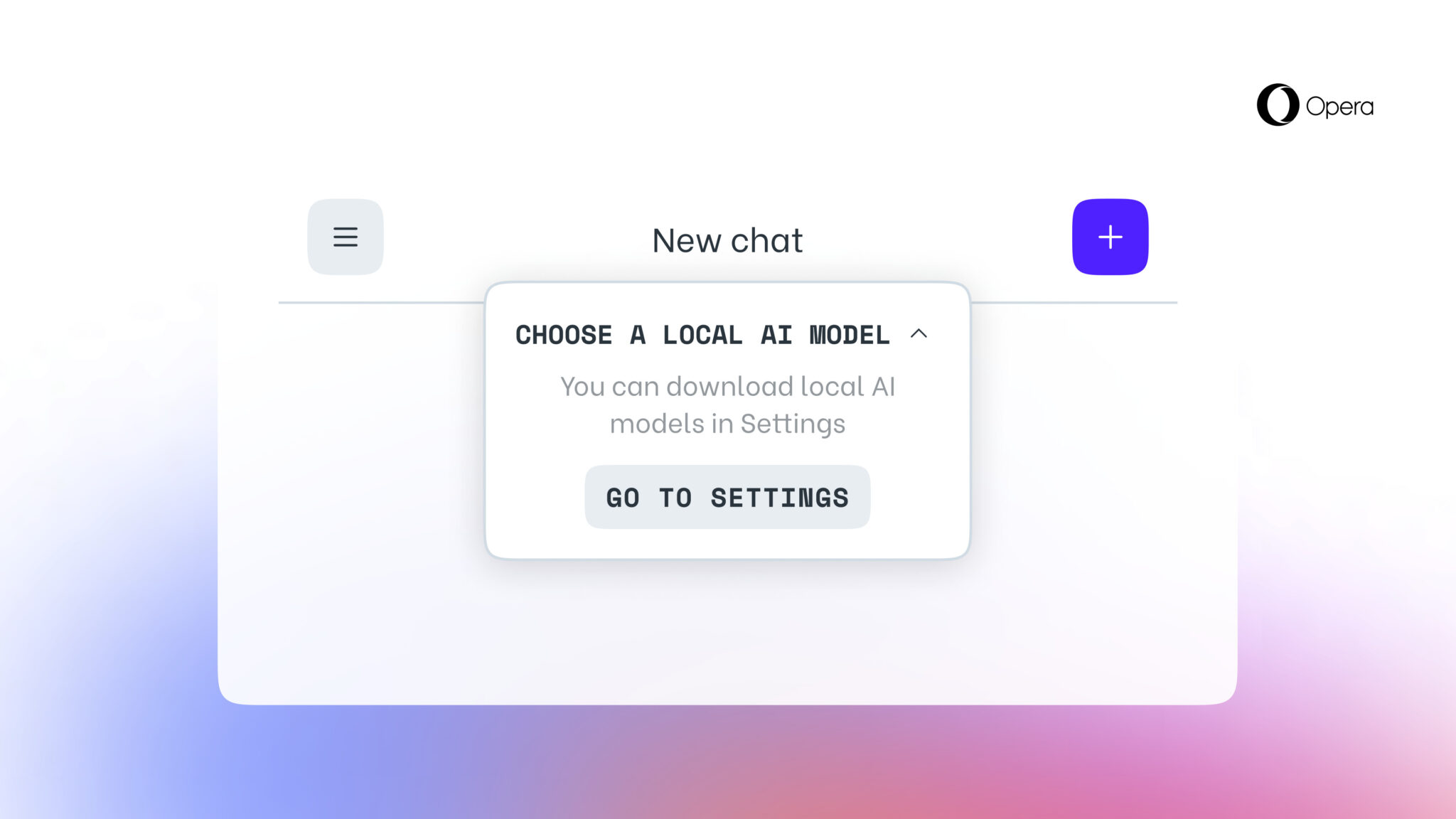

Från och med idag är den nya funktionen tillgänglig för användare av Opera One Developer, men du måste uppgradera till den senaste versionen av Opera Developer och följa steg-för-steg-guiden för att aktivera den.

Det är värt att komma ihåg att när du väljer en specifik LLM kommer den att laddas ner till din enhet. Det är också viktigt att notera att en lokal LLM vanligtvis kräver mellan 2 GB och 10 GB diskutrymme för varje alternativ. När den har laddats ned till din enhet kommer den nya LLM:en att användas i stället för Aria, den inbyggda AI:n i webbläsaren Opera.

Källa: Opera