Med det nya verktyget Nightshade kan konstnärer i smyg korrumpera data för AI-utbildning

University of Chicago

Ett team vid University of Chicago har utvecklat ett verktyg som kallas Nightshade, som ger konstnärer möjlighet att lägga till osynliga pixlar i verk som förstör träningsdata för AI.

Här är vad vi vet

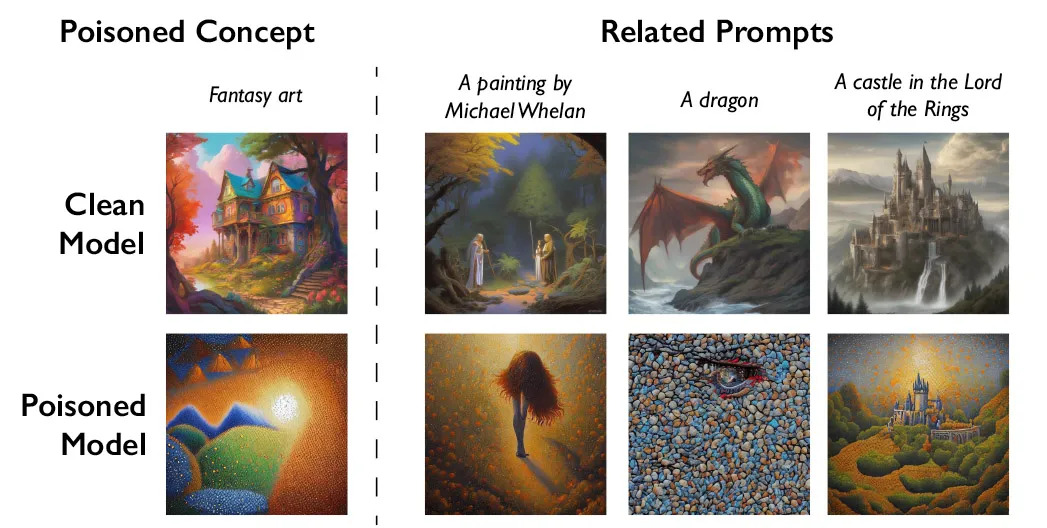

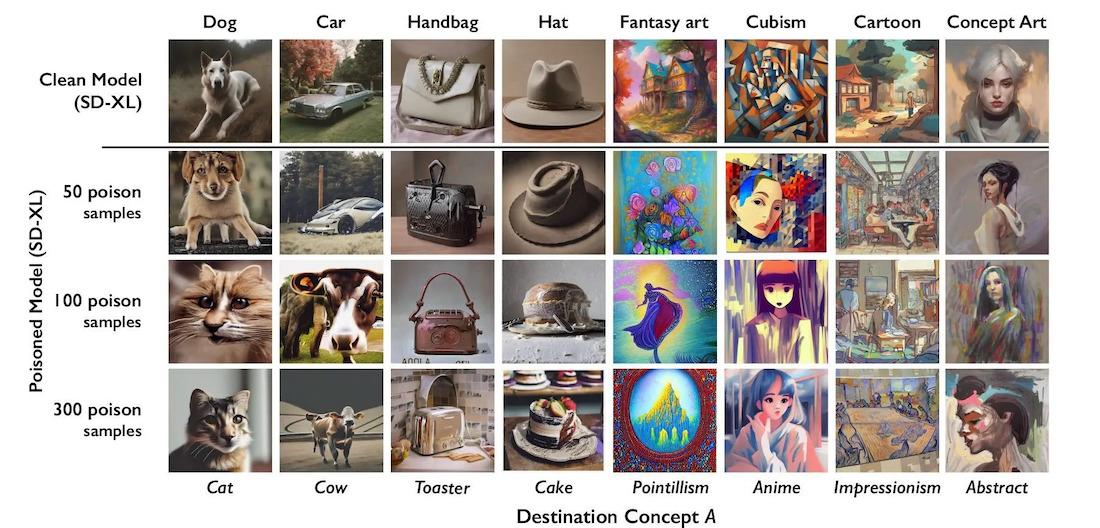

Nightshade fungerar på så sätt att det injicerar ett slags "gift" i träningsdata. Detta får AI att misstolka användarfrågor och producera förvrängt innehåll. Till exempel kan systemet producera en bild av en katt istället för en hund på begäran.

Enligt utvecklarnas plan ska detta tillvägagångssätt uppmuntra företag som OpenAI, som aktivt använder konstnärers data för att träna AI, att begära tillstånd att göra det och betala ersättning. För att ta bort Nightshades korrupta data från träningsprovet skulle de behöva söka manuellt efter varje sådant fragment, vilket är extremt arbetsintensivt.

Verktyget genomgår för närvarande peer review och testning. Utvecklarna har testat sitt arbete på den populära Stable Diffusion-modellen, liksom på sin egen experimentella AI-modell.

Enligt dem är Nightshade inte ett universalmedel, och vissa kan använda det för själviska ändamål. Men för att allvarligt skada AI-träningen skulle angripare behöva lägga till förvrängningar i tusentals konstverk.

Nightshade var det andra verktyget av detta slag efter Glaze, som släpptes av samma team i augusti 2022. Glaze gör också ändringar i bilder som inte märks av människor, vilket skyddar konstnärernas upphovsrätt.

Källa: MIT Technology Review